Download PDF

Download page Инструкции по установке и запуску ПК СВ «Брест» в различных конфигурациях.

Инструкции по установке и запуску ПК СВ «Брест» в различных конфигурациях

Данная статья применима к:

Astra Linux Special Edition РУСБ.10015-01 (очередное обновление 1.6)

с установленным обновлением БЮЛЛЕТЕНЬ № 20190912SE16 (оперативное обновление 3)Astra Linux Special Edition РУСБ.10015-16 исп. 1

с установленным обновлением Бюллетень № 20201007SE16

Введение

В данной документации представлены разделы с инструкциями по установке и запуску стенда ПК СВ "Брест" в конфигурациях:

с разными вариантами хранения данных на СХД - с использованием кластерных файловой системы OCFS2 и менеджера томов LVM;

- с хранением данных в распределенной системе хранения Ceph;

- в доменной среде ALD или FreeIPA;

- в отказоустойчивой, высокодоступной конфигурациях, или без нее.

Документация не дает исчерпывающей информации по настройке сопутствующих систем, таких, как контроллеры домена, СУБД, сетевая инфраструктура и т.д. Приводятся только достаточные конфигурации этих сервисов для запуска облака ПК СВ "Брест" в рамках стендирования.

Требования

- Необходимый уровень подготовки - начинающий администратор Linux;

- В наличии имеются:

- дистрибутив ПК СВ Брест;

- дистрибутив ОС Astra Linux Special Edition РУСБ.10015-01 (очередное обновление 1.6) и актуальное оперативное обновления к нему. Совместимость ПК СВ "Брест" с очередными и оперативыми обновлениями ОС Astra Linux Special Edition описана по ссылке: Среда функционирования обновлений ПК СВ «Брест».

Как читать эту документацию

Документация написана модульно, и для развертывания облака в конкретной выбранной конфигурации нужны только отдельные ее части. Поэтому документация представляет собой набор связанных гиперссылками инструкций, предоставляющих администратору выбор из двух или нескольких вариантов дальнейших действий в зависимости от выбранной конфигурации стенда.

Рекомендуется каждую новую ссылку открывать в отдельной вкладке браузера и после прочтения открывшейся статьи возвращаться к месту, откуда данная статья была вызвана. Так, навигация по документации начинается на этой странице и после завершения действий по настройке всей инфраструктуры предполагается, что администратор вернется на эту же страницу для прочтения заключительных разделов.

Условные обозначения

В инструкциях данной документации принят ряд условных обозначений, как для терминологии, так и для указания значений различных параметров, специфичных для узлов кластера.

Термины и определения:

| № | Термин | Определение | Обозначение на схемах |

|---|---|---|---|

| 1 | Репозиторий | Сервис FTP для предоставления инсталляционных пакетов. | |

| 2 | Контроллер домена | Сервер, выполняющий службы аутентификации и авторизации. | DC-N |

| 3 | Front-end | Сервер, выполняющий роль управления Узлами виртуализации. Также предоставляет веб-интерфейс администратора облака ПК СВ Брест. | FRONT-N |

| 4 | Узел виртуализации | Гипервизор. Сервер, обеспечивающий работу виртуальных машин. | NODE-N |

| 5 | ВМ | Виртуальная машина. | vm |

| 6 | СХД | Система хранения данных – аппаратное (или эмулируемое программно) устройство, предоставляющее блочные данные по сети. | SAN |

| 7 | Узел Ceph | Сервер распределенной системы хранения Ceph. | CEPH-N |

| 8 | АРМ | Автоматизированное рабочее место – рабочая станция администратора или пользователя. |

В листингах команд и конфигурационных файлов будут встречаться условные обозначения устанавливаемых параметров. Такие обозначения всегда заключаются в угловые скобки так: <параметр-N>. При этом в названии самого условного обозначения может стоять символ N, обозначающий порядковый номер. Например, узлов виртуализации обычно больше 1-го, поэтому их IP-адреса могут обозначаться как <node-1-ip>, <node-2-ip> и т.д., или <node-N-ip>.

В следующей таблице приведены все условные обозначения, используемые в документации:

| № | Условное обозначение | Назначение |

|---|---|---|

<local-admin> | Локальный администратор – пользователь, созданный при установке ОС | |

<domain-admin> | Администратор домена | |

<network> | Сеть, например 192.168.1.0 | |

<netmask> | Маска подсети, например 255.255.255.0. | |

<domain> | Имя домена, например brest.local. | |

<hostname> | Имя текущего узла, на котором выполняется настройка. | |

<server-N-ip> | IP-адрес N-го сервера – обобщенное название для разных серверов – front-end, узлов виртуализации и др. | |

<server-N-hostname> | Имя (hostname) N-го сервера – обобщенное название для разных серверов – front-end, узлов виртуализации и др. | |

<dc-N-ip> | IP-адрес N-ного контроллера домена. | |

<dc-N-hostname> | Имя (hostname) N-ного контроллера домена. | |

<ftp-ip> | IP-адрес FTP-сервера. | |

<ftp-hostname> | Имя (hostname) FTP-сервера. | |

<front-N-ip> | IP-адрес N-ной front-end. | |

<front-N-hostname> | Имя (hostname) N-ной front-end. | |

<floating-ip> | Плавающий IP-адрес. Используется в высокодоступных конфигурациях front-end. | |

<floating-name> | Плавающее доменное имя. Используется в высокодоступных конфигурациях front-end. | |

<node-N-ip> | IP-адрес N-ного Узла виртуализации. | |

<node-N-hostname> | Имя (hostname) N-ного Узла виртуализации. | |

<san-ip> | IP-адрес СХД. | |

<ceph-N-hostname> | Имя (hostname) N-ного узла кластера Ceph. | |

<OS-ISO> | Имя ISO-образа установочного диска ОС | |

<OS-upd-ISO> | Имя ISO-образа диска обновления ОС | |

<OS-dev-ISO> | Имя ISO-образа диска разработчика для ОС | |

<OS-dev-upd-ISO> | Имя ISO-образа обновления диска разработчика для ОС | |

<brest-ISO> | Имя ISO-образа дистрибутива ПК СВ Брест |

Конфигурации развертывания

Облако ПК СВ "Брест" может быть развернуто на любом количестве узлов. Однако, при небольшом количестве узлов возникают очевидные ограничения. Например, если облако развернуто на одном узле, при выходе его из строя вся виртуализованная инфраструктура станет недоступна. Или, если развернута только одна машина front-end, то при выходе ее из строя управление облаком станет невозможным, однако, виртуальные машины продолжат работать.

Также ПК СВ "Брест" позволяет гибко объединять роли узлов в пределах одного сервера. Например, front-end может быть объединена с узлом виртуализации на одном сервере.

Ниже приводятся типовые конфигурации стендов и их свойства:

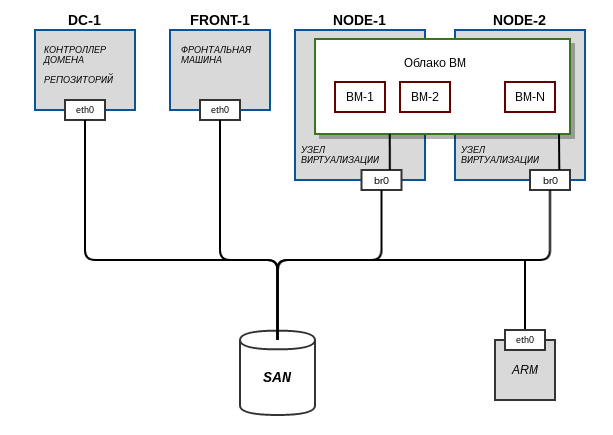

Облако с хранилищем на СХД

Данная конфигурация предназначена для первого знакомства с продуктом.

Поддерживается живая миграция и высокая доступность ВМ.

Не поддерживается высокая доступность системы управления облаком.

Для этой схемы также может использоваться хранилище Ceph.

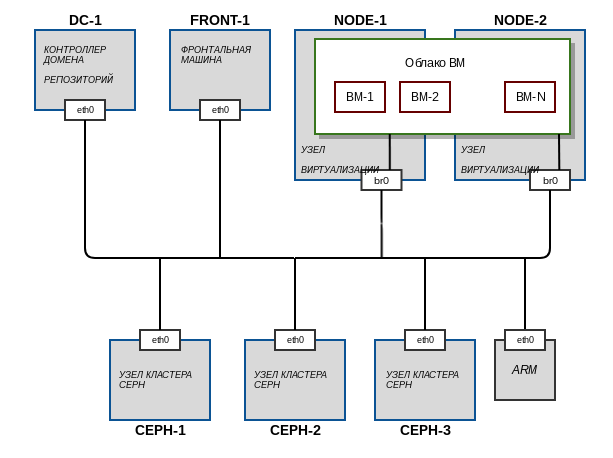

Облако с распределённым хранилищем Ceph

Данная конфигурация предназначена для первого знакомства с продуктом.

Поддерживается живая миграция и высокая доступность ВМ.

Не поддерживает высокую доступность системы управления облаком.

Кластер Ceph также может быть развернут на дисках узлов виртуализации.

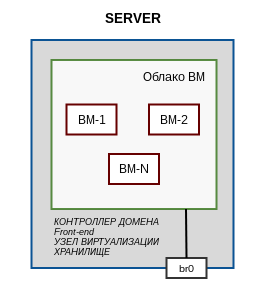

Один сервер

Данная конфигурация применима, когда необходимо управление ВМ через веб-интерфейс, но в наличии только 1 сервер.

В этом случае роли хранилища, front-end, узла виртуализации и контроллера домена разворачиваются на единственном сервере. Нет необходимости иметь СХД.

Не поддерживается миграция и высокая доступность ВМ.

В этой конфигурации используется домен ALD для упрощения процесса настройки.

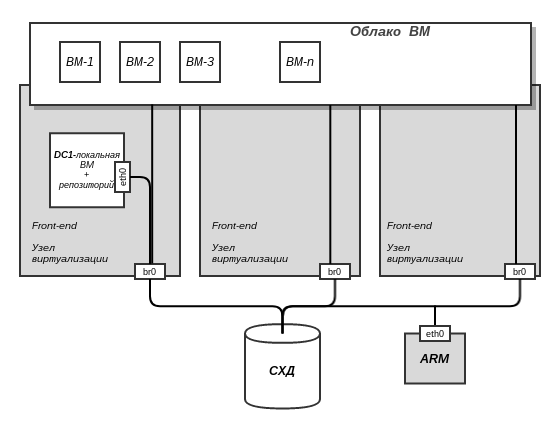

Рекомендуемая схема для конечной производственной инфраструктуры

Обеспечивается высокая доступность front-end (технология RAFT).

При использовании ПК СВ "Брест" 2.6 возможно переместить домен-контроллер в облако.

Аппаратное обеспечение

Облако ПК СВ "Брест" может быть развернуто как на группе физических серверов, так и на виртуальных машинах в пределах одного сервера или рабочей станции для стендирования. Для построения конфигураций, включающих хранение данных на СХД, желательно наличие аппаратно реализованной СХД, однако, в случае ее отсутствия, для стендирования допускается настройка программной СХД. В этом разделе статьи приводятся минимальные рекомендованные характеристики серверов (виртуальных машин) для стендирования и другие условия.

Серверы

В таблице перечислены рекомендованные характеристики серверов или виртуальных машин для разворачивания стенда:

| № | Назначение | Процессор | ОЗУ | Объем диска |

|---|---|---|---|---|

| 1 | Репозиторий | 1 ядро | 512 Мб | 20 Гб |

| 2 | Контроллер домена | 3 ядра | 2 Гб | 20 Гб |

| 3 | front-end | 2 ядра | 2 Гб | 20 Гб |

| 4 | Узел виртуализации | 4 ядра с поддержкой Intel VT-x или AMD-V | 4 Гб | 20 Гб |

| 5 | СХД (в случае отствутствия аппаратной СХД) | 2 ядра | от 1 Гб | 20 Гб - ОС 2 диска по 100 Гб для данных облака |

| 6 | Узел ceph | 2 ядра | от 1 Гб | 20 Гб - ОС 200 Гб для данных облака |

Для работы механизма высокой доступности ВМ облака узлы виртуализации должны быть оборудованы модулем удаленного администрирования IPMI.

Если развертывание осуществляется на виртуальных машинах, на хостовой ОС должна быть включена вложенная виртуализация, см. статью Включение вложенной (nested) аппаратной виртуализации в KVM.

Сеть

В инструкциях данной документации все узлы объединяются в одну физическую или виртуальную одноранговую сеть и имеют по одному IP-адресу. В производственном применении рекомендуется использовать как минимум 2 сети для разделения трафика блочных данных и остального трафика кластера.

Планирование

После выбора конфигурации развертывания рекомендуется составить таблицу-план с указанием имен узлов, адресов и других данных. К такой таблице будет удобно обращаться по ходу выполнения инструкций для поиска необходимых значений. Желательно предполагать возможное развитие стенда и выбрать унифицированную схему именования узлов, а также зарезервировать ip-адреса для дальнейшего применений.

Важной функцией этой таблицы будет являться сопоставление условных обозначений принятых в документации адресов и имен ролей серверов их реальным значениям на Вашем оборудовании. Например, Вы решили объединить роль узла виртуализации и узла кластера ceph на одном сервере с действительным именем myhost2 и зафиксировали это в плане. Теперь, если в документации встретится действие, которое нужно выполнить на узле <ceph-2-hostname> будет очевидно, что его нужно сделать на myhost2.

Для примера ниже приводится план стенда по рекомендованной конфигурации Облако с хранилищем на СХД (описание конфигурации см. выше):

| № | Узел | Роль | Условное имя | Действительное имя узла | Доменное имя полное | IP-адрес | Примечание |

|---|---|---|---|---|---|---|---|

| Сервер №1 | Контроллер домена Репозиторий |

|

| dc1.brest.local | 192.168.1.1 | ||

192.168.1.2 | Зарезервировано для вторичного контроллера домена dc2 | ||||||

192.168.1.3 | Зарезервировано для вторичного контроллера домена dc3 | ||||||

| Сервер №2 | front-end | <front-1-hostname> | front1 | front1.brest.local | 192.168.1.5 | ||

192.168.1.6 | Зарезервировано для второй front-end front2 | ||||||

192.168.1.7 | Зарезервировано для третьей front-end front3 | ||||||

192.168.1.8 | Зарезервировано для "плавающего" высокодоступного адреса RAFT | ||||||

| Сервер №3 | Узел виртуализации | <node-1-hostname> | node1 | node1.brest.local | 192.168.1.11 | ||

| Сервер №4 | Узел виртуализации | <node-2-hostname> | node2 | node2.brest.local | 192.168.1.12 | ||

| Зарезервированы для дополнительных узлов виртуализации | ||||||

| Сервер №5 | СХД | - | san | - | 192.168.1.20 |

Итого, на начальном этапе для реализации облака в данной конфигурации нужно 4 сервера (+1, если нет СХД).

Порядок развертывания

В первую очередь на серверах необходимо развернуть ОС Astra Linux Special Edition 1.6 с необходимыми обновлениями и настроить сеть. Кратко шаги по установке изложены в инструкции Установка ОС. Детально об установке можно почитать в соответствующем разделе Справочного центра.

Далее в соответствии с тем, как распределены роли по узлам в определенном ранее плане, необходимо последовательно переходить к разделам по настройке данных ролей на конкретных серверах.

- Создать сетевой репозиторий в соответствии со статьей Разное ⬝ Настройка FTP-репозитория.

- Развернуть контроллер домена в соответствии со статьей Контроллер домена.

- После настройки домена развернуть Фронтальная машина.

- Подготовить Узлы виртуализации.

- Перейти к разделу Хранилище данных.

- Если требуется обеспечить высокую доступность front-end - перейти к разделу RAFT.

После выполнения соответствующих вашей конфигурации инструкций, из указанных разделов, развертывание облака ПК СВ "Брест" закончено.

Дальнейшие действия

После развертывания облака ознакомьтесь с тем, как настраиваются виртуальные сети, хранилища, виртуальные машины, например, воспользовавшись статьей Управление виртуализацией ПК СВ "Брест". Для проверки работоспособности облака создайте ВМ, запустите ее и выполните миграцию на другой узел виртуализации.

Так же для работы в облаке нескольких пользователей или администраторов, необходимо добавить в домен рабочие места и использовать их для подключения к веб-интерфейсу управления облаком. В статье Назначение прав пользователям для запуска ВМ opennebula описан процесс организации подобной работы в части настройки ПК СВ "Брест".

С другими статьями вы можете ознакомиться в Справочном центре по ссылке Программный Комплекс Средств Виртуализации "Брест"

Обновление

При выходе новых обновлений ПК СВ "Брест", или обновлений ОС, узлы кластера необходимо обновить. Рекомендации по обновлению приведены на странице Обновление ПК СВ Брест.